Nuestros servicios

Impulsamos la innovación tecnológica a través de nuestro portafolio de soluciones para mejorar la productividad y competitividad de las empresas.

Descubre nuestro

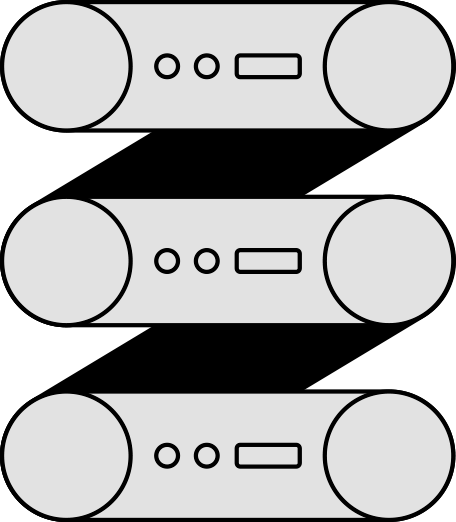

Data Center

principal

Rated-3

Acompáñanos a conocer nuestro nuevo Data Center, diseñado y construido para cumplir con la doble certificación del estándar TIA 942 (Design - Construction).

Contamos con

Nuestro

Propio

Centro de Atención

Cada vez que un cliente llama frente a una incidencia es atendido por un ingeniero certificado en networking y seguridad.

Nuestros Partners

Contamos con alianzas estratégicas con los principales fabricantes de tecnología, líderes en la transformación digital.

WIN Cloud

Servicios en la nube

para tu

empresa

Descubre WIN Cloud, la nube privada para la continuidad de tu negocio, con soluciones de infraestructura digital (IaaS), almacenamiento y respaldos de información (BaaS), recuperación de desastres (DRaaS), entre otros.

Softphone móvil

Soluciones en telefonía corporativa

Incremente la productividad de su equipo de trabajo con una aplicación flexible, segura y rápida para realizar llamadas desde cualquier lugar con su teléfono móvil.

Webinars

sobre TI

Aprende más sobre las tecnologías que están impactando positivamente a las empresas con nuestros webinars sobre ciberseguridad, transformación digital, tecnologías cloud entre otros.